自然语言处理的6大法宝

本文共 1926 字,大约阅读时间需要 6 分钟。

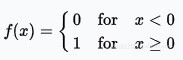

阶跃函数

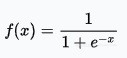

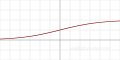

Sigmoid函数

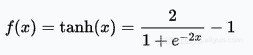

双曲正切函数

线性修正单元函数

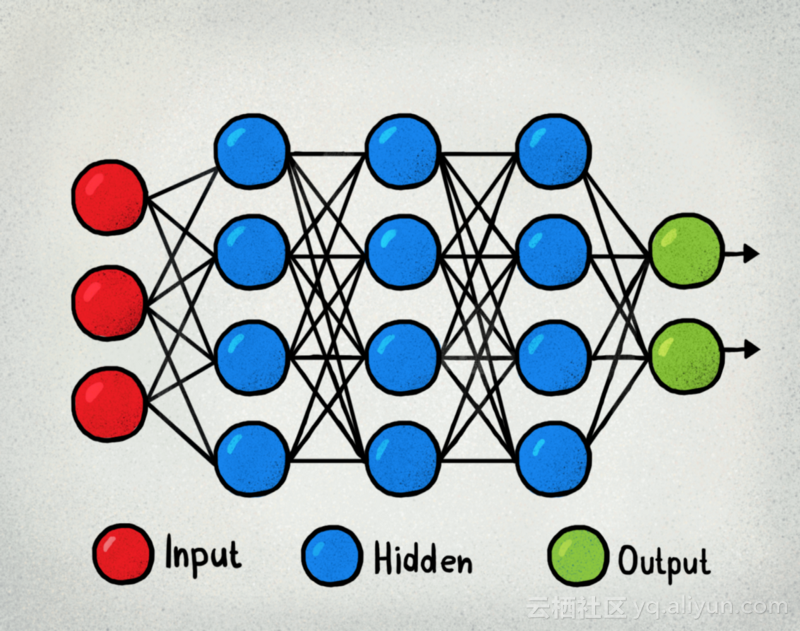

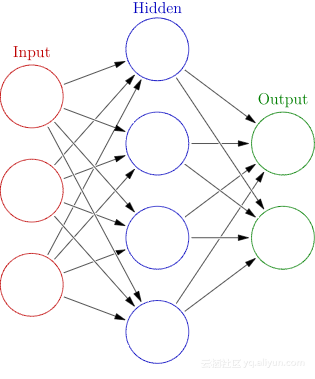

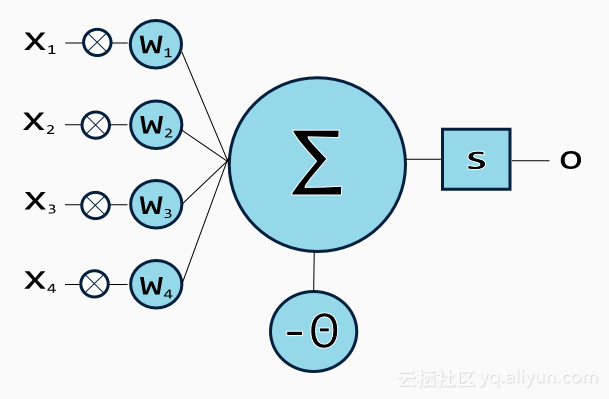

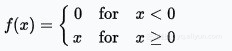

1.多层感知器(MLP)

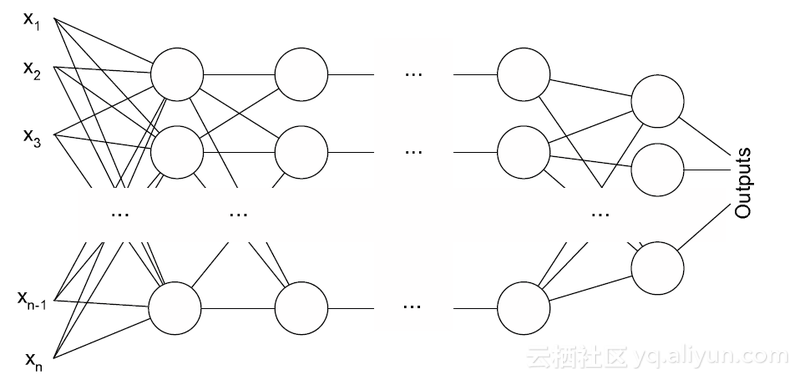

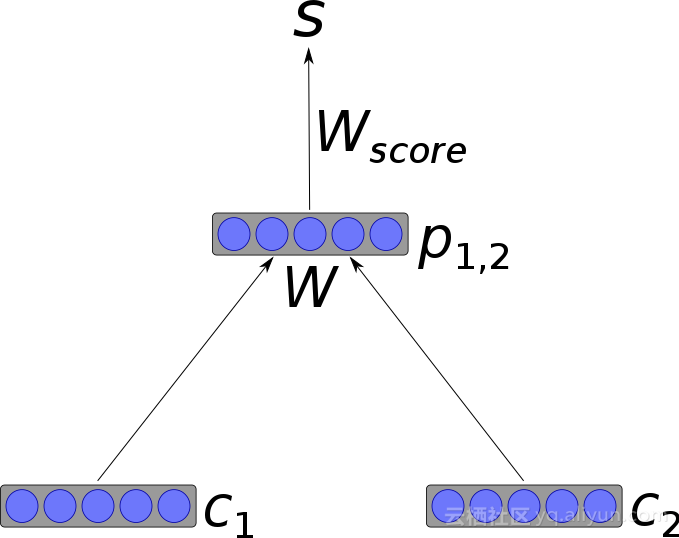

2.卷积神经网络(CNN)

3.递归神经网络(RNN)

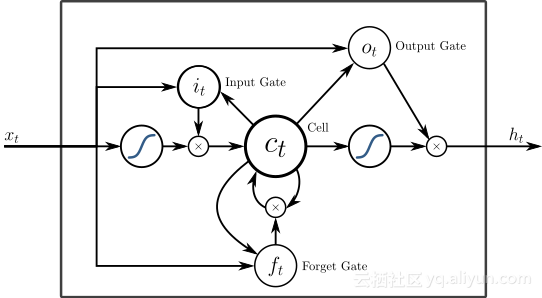

4.长短期记忆网络(LSTM)

长短期记忆网络,是一种时间递归神经网络,适合于处理和预测时间序列中间隔和延迟相对较长的重要事件。它是一种含有LSTM区块神经网络,在文献或其他资料中LSTM区块可能被描述成智能网络单元,因为它可以记忆不定时间长度的数值,区块中有一个“门”能够决定输入值是否重要到能被记住以及能不能被输出。

在大规模声学建模和词性分类方面,长短期记忆网络被证明拥有优异性能。5.序列-序列模型

6.浅层神经网络

除了深层神经网络外,浅层模型也是实用且广受欢迎的工具。例如,word2vec是一组浅层模型,用于生成词向量。word2vec可以在百万数量级的词典和上亿的数据集上进行高效地训练,训练结果——词向量可以很好地度量词与词之间的相似性。

总结

在本文中,我们介绍了人工神经网络的不同变体,如多层感知器、卷积神经网络、递归神经网络、长短期记忆网络、序列-序列模型以及浅层神经网络。我们展示了这些网络如何运作,以及它们在自然语言处理任务中的具体应用。我们发现,卷积神经网络主要用于文本分类,而递归神经网络通常用于自然语言生成或机器翻译。

作者:Olga Davydova

以上为译文

本文由老师推荐,组织翻译。

文章原标题7 Types of Artificial Neural Networks Language Processing,作者:,译者:Anchor C.,审阅:虎说八道。

文章为简译,更为详细的内容,请查看

转载地址:http://uwhtx.baihongyu.com/

你可能感兴趣的文章

网站分析系统

查看>>

从零开始来看一下Java泛型的设计

查看>>

Shell编程基础

查看>>

Shell之Sed常用用法

查看>>

3.1

查看>>

校验表单如何摆脱 if else ?

查看>>

JS敏感信息泄露:不容忽视的WEB漏洞

查看>>

分布式memcached服务器代理magent安装配置(CentOS6.6)

查看>>

Create Volume 操作(Part III) - 每天5分钟玩转 OpenStack(52)

查看>>

tomcat 8.0虚拟机配置文档

查看>>

pxc群集搭建

查看>>

JS中加载cssText延时

查看>>

常用的脚本编程知识点

查看>>

XILINX_zynq_详解(6)

查看>>

计算机网络术语总结4

查看>>

新手小白 python之路 Day3 (string 常用方法)

查看>>

soapUI的简单使用(webservice接口功能测试)

查看>>

框架 Hibernate

查看>>

python-while循环

查看>>

手机端上传图片及java后台接收和ajaxForm提交

查看>>